Las estafas de IA son cada vez más inteligentes y difíciles de detectar

La inteligencia artificial está cambiando la forma en que se crean,ásinteligentesydifíMercado de divisas del dólar estadounidense en tiempo real escalan y distribuyen las estafas. Ahora se utilizan herramientas como generadores de imágenes, chatbots y sintetizadores de voz para hacerse pasar por personas, automatizar mensajes de phishing y producir productos falsos que no existen. Con una entrada mínima y casi sin coste, los estafadores pueden producir material convincente en cuestión de segundos.

Según el informe Global State of Scams 2024 de la Global Anti-Scam Alliance (GASA), muchas víctimas de estafas creen que se utilizó IA en los mensajes de estafa que recibieron, sobre todo a través de texto, chat o voz. El 31% no estaba seguro y el 16% dijo que la IA no estaba implicada.

Casi la mitad de las estafas se completan ahora en 24 horas, un ritmo impulsado en parte por la velocidad y la automatización que permite la IA generativa. Los sitios web de estafas, los correos electrónicos de phishing, los apoyos falsos y las llamadas de suplantación de identidad se pueden crear, desplegar y ampliar en una fracción del tiempo que antes se tardaba.

En este artículo, analizamos cómo los estafadores ya están utilizando la IA de formas que son fáciles de pasar por alto, y a qué puede estar atento para evitar caer en su trampa.

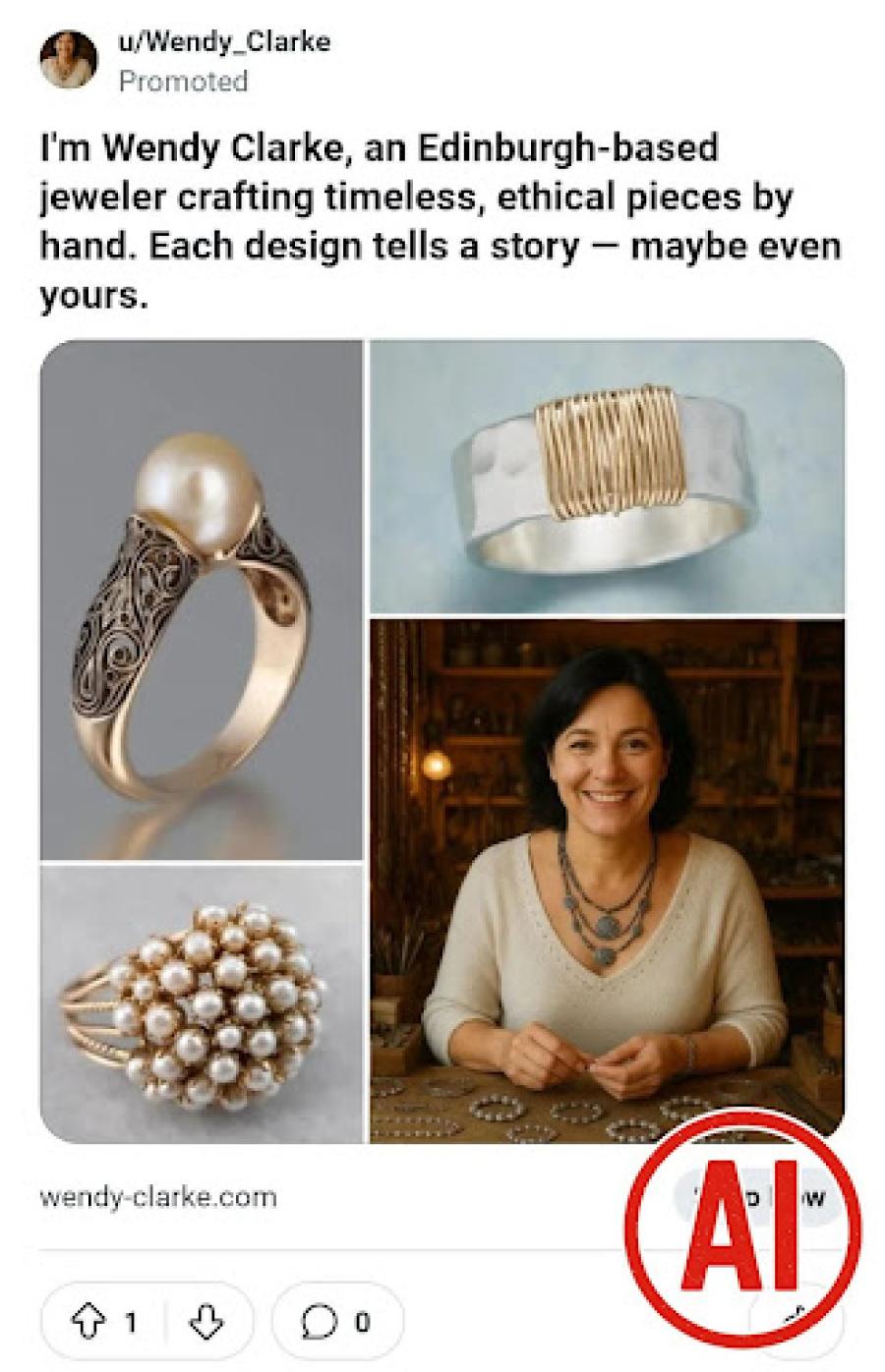

Tiendas en línea falsas que utilizan imágenes generadas por IA

Los generadores de imágenes de IA han facilitado la producción de fotos originales de productos que parecen realistas y profesionales. Los estafadores ya no necesitan robar imágenes de otros vendedores. En su lugar, generan nuevas imágenes de ropa, aparatos electrónicos o muebles que parecen atractivas pero que en realidad no existen.

Estas imágenes se utilizan para crear tiendas en línea falsas y publicar anuncios en las redes sociales. Aunque los elementos visuales parecen pulidos, una inspección más minuciosa revela a menudo marcas distorsionadas, proporciones extrañas, texto deformado o iluminación poco natural. Las víctimas son atraídas con grandes descuentos y promociones urgentes. Tras el pago, no suelen recibir nada o un producto falsificado.

Correos electrónicos de phishing escritos con modelos lingüísticos

Loscorreos electrónicos de phishing se han basado durante mucho tiempo en la urgencia y la suplantación de identidad, pero su lenguaje a menudo los delataba. Esto ya no es así. Ahora, las herramientas de redacción basadas en inteligencia artificial pueden crear mensajes de phishing que suenen naturales y se ajusten al tono de las instituciones legítimas.

Los estafadores pueden generar rápidamente correos electrónicos de aspecto realista que imitan mensajes de bancos, servicios gubernamentales o empresas conocidas. También pueden adaptar la redacción en función de la época del año o la ubicación, como recordatorios de presentación de impuestos o avisos de entrega de paquetes. Estos mensajes suelen llevar a páginas de inicio de sesión falsas o incitan a los destinatarios a descargar programas maliciosos.

Clonación de voz utilizada en estafas de suplantación de identidad

Con un breve clip de audio, los estafadores pueden generar voces sintéticas que suenan como las de personas reales. Esta tecnología se utiliza cada vez más en estafas de suplantación de identidad.

Algunas estafas incluyen llamadas en las que la voz suena igual que la de un ser querido en apuros. La FTC ha advertido de que los estafadores pueden ahora clonar voces utilizando IA, lo que hace que las estafas de emergencia familiar sean aún más difíciles de detectar. Con sólo un breve clip de audio, los estafadores pueden crear una voz que suene lo bastante real como para engañar a la gente haciéndole creer que un familiar está en apuros.

Esta misma tecnología ya se ha utilizado en estafas a empresas. En un caso, una empresa energética del Reino Unido transfirió más de 243.000 dólares tras recibir una llamada que imitaba la voz de su director general.

Vídeos deepfake en esquemas de inversión falsos

Las estafas basadas en vídeos también están evolucionando. La tecnología Deepfake permite a los estafadores crear vídeos falsos en los que aparecen personas conocidas para promocionar plataformas de inversión o regalos. Estos vídeos se utilizan a menudo para captar usuarios de redes sociales o aparecen en anuncios en línea.

Los estafadores han utilizado deepfakes de Elon Musk, Anthony Bolton y Taylor Swift para promocionar plataformas de criptomonedas y planes de inversión fraudulentos. Estos vídeos suelen ir acompañados de lenguaje "por tiempo limitado" y grupos de WhatsApp fraudulentos. Un ejemplo real de esta táctica es visible en este video compartido por FTI, donde se utilizó un livestream hackeado para impulsar una estafa de criptomonedas con temática de Musk.

Cómo detectar las estafas generadas por IA

Los elementos visuales generados por IA suelen contener incoherencias físicas. Busque telas deformadas, reflejos desajustados, errores de iluminación o logotipos ausentes en anuncios o fotos de productos. Si algo parece demasiado pulido pero carece de un origen rastreable, sea escéptico.

Los mensajes creados por IA pueden sonar demasiado pulidos o genéricos. Las estafas que no hacen referencia a ningún contexto personal o que utilizan una redacción que parece un poco rara merecen ser cuestionadas, sobre todo si proceden de personas conocidas.

Los vídeos y audiosdeepfake pueden reutilizar guiones familiares o parecer emocionalmente planos. Si una emisión en directo o un anuncio muestra a un famoso avalando un plan de inversión, busca sus redes sociales verificadas antes de creerlo o compartirlo.

Conclusión: Mantenerse alerta

La IA generativa está haciendo que las estafas sean más rápidas, más escalables y más difíciles de detectar. Las señales que antes las delataban (mala gramática, imágenes robadas, frases incómodas) están desapareciendo.

Pero aún hay formas de detectar la diferencia. Los enlaces desconocidos, las solicitudes de pago urgentes y los mensajes fuera de lugar de personajes públicos o seres queridos deben tratarse con desconfianza. Pero si vas más despacio, compruebas los detalles y reflexionas críticamente sobre lo que ves o escuchas, puedes evitar que las prisas te atrapen.

Recomendaciones relacionadas

- Presentación de Herbaltops.com: ¿Real o un Truco?

- 【早盘】需求略有降温 金价延续震荡

- Protéjase de la estafa del número equivocado: Advertencia sobre las tácticas de ingeniería social

- ¿Es seguro Slimreme.com? Descubriendo Banderas Rojas en Nuestra Investigación

- 8月1日 黄金主观个人分析:

- ¿Señal de compra? XRP se prepara para una acción explosiva del precio después de la consolidación

- ¿Es Nobleal.online falso o real?

- Guía para jóvenes: Sea astuto en Internet

Noticias de FTI

Noticias de FTI